뒤쪽레이어에서는 시그모이드 써도 되지만 앞쪽에서 sigmoid쓰면 0으로 수렴해버림

-> 초반에는 ReLU함수를 많이 씀

https://playground.tensorflow.org

* 소프트맥스 : 분류문제에서 입력값 중 최대의 값을 극대화해서 T/F를 판단

다른 값들도 영향주긴 하지만 가장 큰 값이 결과에 영향을 줄 가능성이 큼.

두가지 선택지 중 하나 = 1bit

ex) 4가지 중 1의 답 = log24 = 2

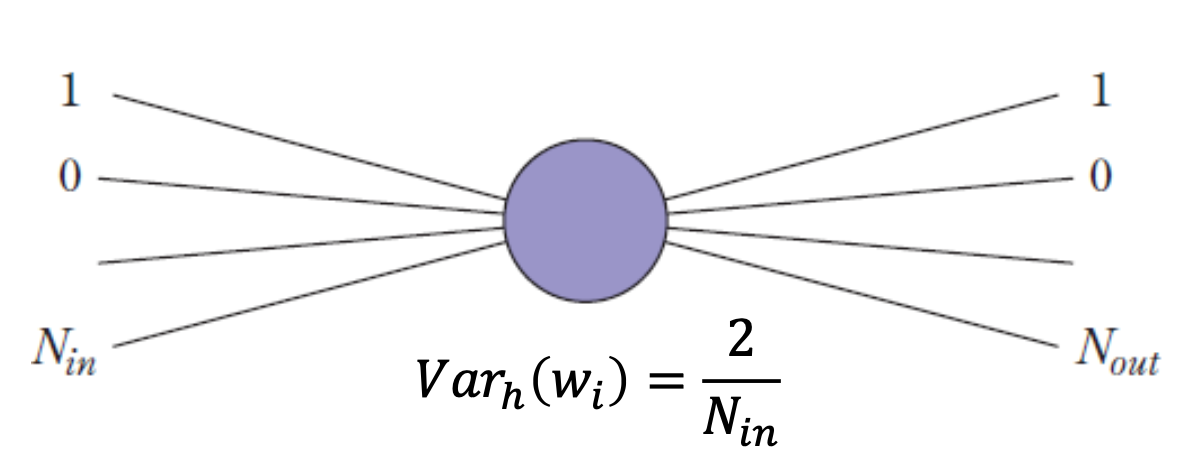

가중치 초기값은 0으로 하면 대칭성을 이뤄서 제대로된 역전파 값이 안나옴

초기값은 작은 난수로 설정해서 겹치지 않게 해야함

* ReLU에서 2를 곱해주는 이유 : 시그모이드에서 ReLU로 갈 때 음수 부분이 없어지기 때문에 보상해주기 위해 2배로 곱함

? : 원핫인코딩 (1,0,1),(1,1,0),(0,1,1)로 안하는 이유